E-Mail: [email protected]

- Qwen3 a 30 miliardi di parametri su Raspberry Pi 5.

- 8.03 TPS a 2.70 BPW con il 94.18% qualità BF16.

- ByteShape: 8.5 TPS e accuratezza superiore al 92%.

- RTX 5090: sweet spot a circa 4 bit.

- Costo di Raspberry Pi 5: circa 170 euro.

Qwen3 a 30B su Raspberry Pi

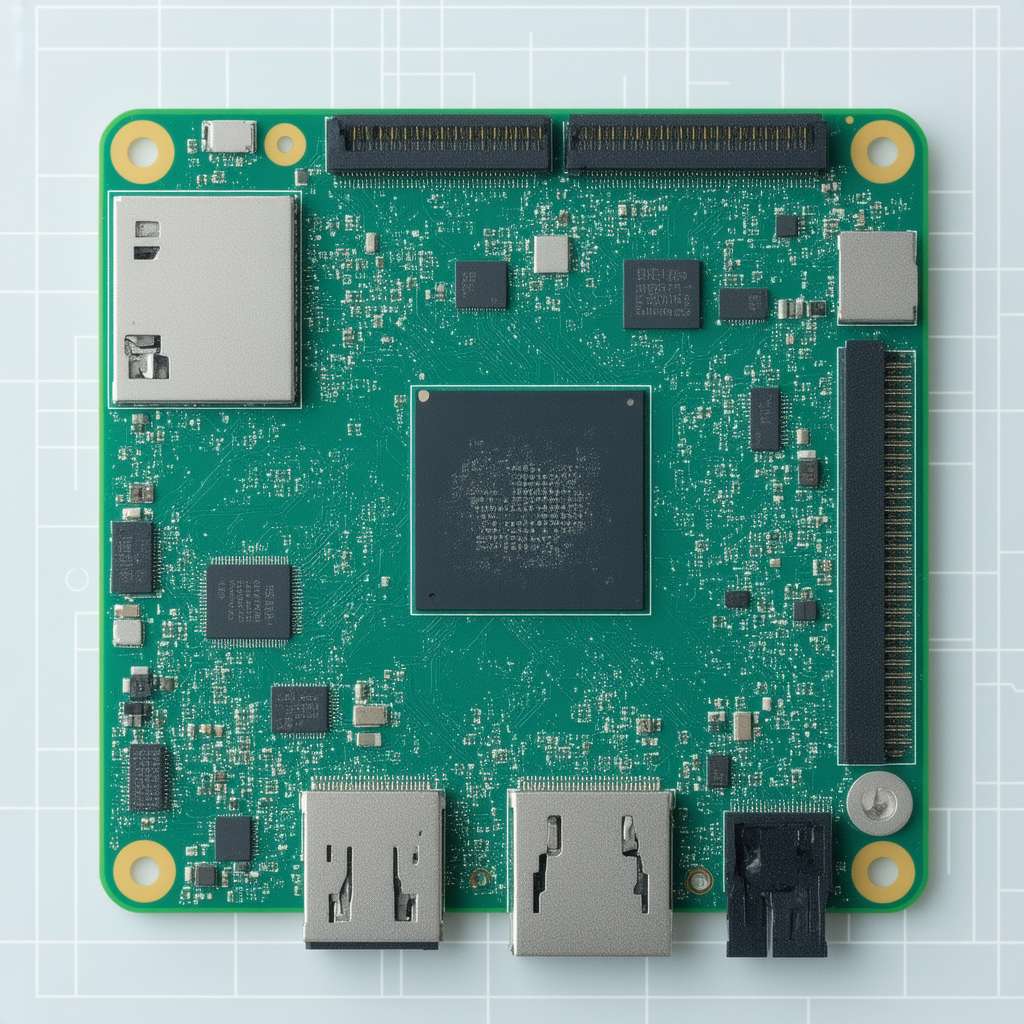

Il 2026 segna un punto di svolta nell’accessibilità dell’intelligenza artificiale. Un modello linguistico di grandi dimensioni, Qwen3 con 30 miliardi di parametri, è stato portato a funzionare in tempo reale su un Raspberry Pi 5, una macchina dal costo di circa 170 euro. Questo risultato, che sembrava impensabile fino a poco tempo fa, apre nuove prospettive per l’utilizzo di modelli AI avanzati in contesti con risorse limitate.

Il team di sviluppo ha ottimizzato il modello Qwen3-30B-A3B-Instruct-2507 utilizzando ShapeLearn, una metodologia di apprendimento del tipo di dato. L’obiettivo? Massimizzare le prestazioni in termini di token al secondo (TPS) e qualità dell’output, rispettando il vincolo della memoria disponibile. *La chiave è trattare la memoria come un budget da rispettare, per poi ottimizzare ciò che conta davvero: TPS e qualità.

Su un Raspberry Pi 5 con 16GB di RAM, il modello Q3_K_S-2.70bpw [KQ-2] raggiunge 8.03 TPS a 2.70 BPW (bits per weight), mantenendo il 94.18% della qualità BF16. Questo significa un’esperienza utente che si avvicina al tempo reale.

Analisi comparativa: ByteShape vs. Unsloth

I modelli ByteShape offrono un miglior compromesso tra TPS e qualità rispetto alle alternative, come Unsloth. Su CPU, la riduzione dell’impronta tramite bitlength più brevi influenza il tradeoff tra TPS e accuratezza. Se i tipi di dati sono selezionati correttamente, è possibile sacrificare un po’ di qualità per la velocità in modo prevedibile.

Su Raspberry Pi 5 con 16GB di RAM, ByteShape raggiunge 8.5 TPS con un’accuratezza superiore al 92%. Questo risultato ridefinisce le aspettative per i sistemi di classe Pi. In generale, ShapeLearn produce modelli migliori, con ByteShape che supera Unsloth, ottenendo più token al secondo con la stessa qualità, o una qualità superiore con la stessa velocità di elaborazione.

Quando si ottimizza per il tempo di risposta mantenendo l’accuratezza, ByteShape (2.70 BPW, 8.03 TPS, 94.18% accuratezza) è la scelta ideale per l’utilizzo interattivo on-device. Rispetto ai modelli Unsloth con qualità simile, ByteShape raggiunge prestazioni in tempo reale con BPW inferiori e TPS superiori.

- 🚀 Impressionante! Qwen su Raspberry Pi apre scenari incredibili......

- 🤔 Ma siamo sicuri che questa ottimizzazione estrema non comprometta......

- 🤯 E se usassimo questa potenza per creare un sistema di monitoraggio......

Performance su GPU: RTX 5090 e RTX 4080

Le prestazioni su GPU dipendono tanto dalla scelta del kernel quanto dall’impronta di memoria grezza. Per matmul/matvec, i percorsi di decodifica GPU specifici per la quantizzazione di llama.cpp comportano overhead molto diversi. Meno bit per peso non si traducono automaticamente in TPS più elevati. Invece, il TPS spesso raggiunge picchi in punti ottimali specifici per la quantizzazione.

Su una RTX 5090 (32 GB), si osserva un chiaro sweet spot a circa 4 bit. Diversi modelli a ~4b si raggruppano a TPS molto elevati con una qualità quasi identica. Al di fuori di questo sweet spot, il tradeoff diventa molto più irregolare. Solo ByteShape continua ad aumentare il TPS con una riduzione più prevedibile della qualità.

Su una RTX 4080 (16 GB), ByteShape supera costantemente Unsloth con lo stesso vincolo di 16 GB di VRAM, offrendo un miglior tradeoff TPS–qualità.

Le insidie della quantizzazione: quando meno non significa più

Ridurre le dimensioni dei dati non accelera automaticamente le cose. Le GPU NVIDIA elaborano il lavoro in gruppi fissi di 32 thread chiamati “warp”, che si muovono attraverso le istruzioni insieme in quasi lock-step. L’hardware della GPU è ottimizzato per formati di dati, modelli di accesso alla memoria e operazioni specifici.

Se il carico di lavoro corrisponde a questi “golden path”, si ottiene il massimo delle prestazioni. In caso contrario, si verificano rallentamenti. Questo spiega perché i kernel a 4 bit utilizzano la larghezza di banda VRAM in modo più efficiente rispetto ai kernel a 3 o 2 bit e richiedono meno passaggi di decodifica prima del calcolo.

Llama.cpp privilegia la quantizzazione portatile ed efficiente in termini di spazio che può essere eseguita su un’ampia gamma di hardware. Questo obiettivo di progettazione limita il modo in cui i backend possono rimodellare i layout dei dati o riordinare il calcolo in modi che potrebbero aiutare una GPU o una larghezza di bit.

Conclusioni: Memoria come vincolo, non come obiettivo

Il vero punto di svolta è considerare la memoria come un vincolo, non come un obiettivo. Una volta che un modello si adatta al dispositivo, ciò che conta è la curva di tradeoff, TPS contro qualità. ByteShape si posiziona costantemente sul lato migliore di quella curva, offrendo più velocità alla stessa qualità o una qualità superiore alla stessa velocità.

Se si effettua il deployment su un Raspberry Pi 5 (16 GB) e si desidera un’esperienza in tempo reale, la scelta è chiara. Su CPU o GPU più grandi, è possibile spostarsi verso punti di qualità superiore con poca perdita di velocità di elaborazione. La regola è sempre la stessa: adattare prima, quindi ottimizzare il tradeoff.

L’automazione in questo contesto si riferisce alla capacità di eseguire modelli di intelligenza artificiale complessi su dispositivi edge, come il Raspberry Pi, senza la necessità di una connessione cloud costante. Questo permette di automatizzare processi decisionali e di analisi direttamente sul campo, riducendo la latenza e aumentando la privacy.

Una nozione avanzata di scalabilità produttiva è rappresentata dalla capacità di adattare dinamicamente la precisione dei modelli (attraverso la quantizzazione) in base alle risorse disponibili. Questo significa poter eseguire lo stesso modello su hardware diversi, ottimizzando le prestazioni in base alle limitazioni specifiche di ciascun dispositivo.

La trasformazione digitale* in atto è evidente nella democratizzazione dell’accesso all’intelligenza artificiale. Non è più necessario un data center per eseguire modelli complessi; ora è possibile farlo su un dispositivo che costa meno di 200 euro. Questo apre nuove opportunità per l’innovazione in settori come l’IoT, la robotica e l’automazione industriale.

È tempo di ripensare il modo in cui concepiamo l’intelligenza artificiale. Non più un lusso riservato a pochi, ma uno strumento accessibile a tutti. La sfida ora è capire come sfruttare al meglio questa nuova potenza di calcolo distribuita per risolvere problemi reali e migliorare la vita delle persone.